【导言】在做网站分析的漫长历程中,被问到最多的问题就是“你的数据精确吗?”网站分析的数据究竟准确与否,如何看待网站分析数据可能存在的偏差,本文将会给出答案。

【正文】

准确和精确在汉语里面是近义词,我们在口语中是可以混用的,英语中也如此,accurate和precise人们也是随性而用,脱口而出。可是,既然有两个词存在,而没有在文字演化的长河中消亡其中一个,就说明它们还是有微妙的不同。事实上,准确和精确绝对不是同一个概念,它们在工程学、统计学以及其他许许多多的科学中都被严格的区分,对于网站分析这么新兴的学科而言,也完全如此。

我们先看看准确和精确到底有什么不同,然后再看看网站分析工具能够做到准确还是精确,或是二者皆备。

———————我是快乐的分页符(点击文章标题看全文)———————

何为准确,何为精确

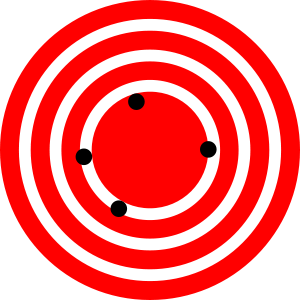

维基百科上有关于准确和精确的极佳的解释,堪称经典词条。这里我用汉语向它致敬:准确是指现象或者测量值相对事实之间的离散程度小,也就是我们口语的“接近事实、符合事实”等;精确是指在条件不变的情况下,现象或者测量值能够低离散程度的反复再现,也就是我们口语说的“次次如此、回回一样”等。下面这两个图特别经典,从维基百科引用而来:

图1:这是指相对较高的准确度,但相对较低的精确度

图2:这是指相对较高的精确度,但相对较低的准确度

上面的两个图中红色的圆心代表着事实。可以看到,在图1中,测量值围绕着圆心,虽然分布离散,但可以看出它们的平均分布位置肯定在圆心中(或者说,多次测量值的平均值是符合事实的),所以可以称为准确,但因结果离散而不能称为精确。在图2中,测量值明显偏离圆心(测量值的平均值也不可能在圆心上),所以不能称为准确,但可以称为精确,因为测量值的复现离散度很低。这是对准确和精确的极好解释。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

如果我们把准确和精确作为两个不同的维度建立矩阵,可以得到下面的图:

图3:准确和精确矩阵(图片来源:www.wellesley.edu)

左上象限是我们最喜欢的,既准确,且精确——对物理学和绝大多数理工科的要求就是如此;右下角是最糟糕的情况,不仅不精确,而且不准确——这是生活中最常见的,我们的社会生活其实很离散也很混沌。

那么,自然而然的你会问,网站分析属于哪个象限呢?一定是左上角的象限对吗?

网站分析是准确的吗?

首先,这个问题没有固定的答案,因为网站分析的准确度很大程度上取决于你的期望和所采用的监测方法和所使用的工具。不过,就我们最常使用的网站分析方法而言,网站分析绝对不属于图3中左边的两个象限(即不属于既准确又精确的象限,也不属于准确但不精确的象限),更简单说,就是网站分析的数据不会准确。

这可能会让你失望,但相信并不出乎你的意料。你肯定已经发现,如果我们使用不同的网站分析工具衡量同一个网站的时候,各工具的结果之间有令人费解的差异(我们在为什么两个监测工具报告中的数据不同有探讨个中原因),而且我们也无法知道哪个工具是更准确的还原了事实上的数据。

所以,如果GA显示你的网站在一个月内有36,954个Unique Visitor,你的网站的真实访问者(一个个活生生的网友!)肯定不是36,954个!

事实上,我们几乎找不出来任何一个能够准确被统计的度量,即使是最基本最简单的度量——Page View也是如此!

因此,如果你的老板想要100%没有误差地知道网站到底有多少个人访问过,这个想要本身已经没有意义。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

为什么网站分析数据无法准确

你可能会吃惊,因为我们的物理学实际上也是不可能100%准确的,原因是我们都听说过的“测不准原理”。同样,网站分析也因为一个最基本的事实而无法准确,即:网站分析的监测媒介是浏览器和服务器,而不是真实的人,这注定了我们不可能寻求到准确的结果。

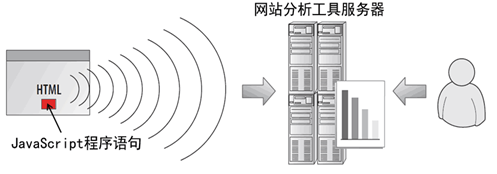

具体而言,就目前我们通常使用的两种监测方法——Server Log和Page Tag都不可能准确对网站分析的一些最基本度量进行计数。

- Unique Visitor的误差:

如果用Server Log的方法监测数据,那么很显然,获取真实的访问者数量是不可能的任务。本身Server Log对于访问者的估算只能依据误差巨大IP,而网络爬虫/机器人的访问又使这种误差进一步扩大。

- Page View的误差:

本来Server Log是可以很准确的记录Page View的,但是可惜Cache的出现让这成为历史。Cache极有可能会屏蔽服务器端的响应,这样Server Log可能不会留下任何关于某次Page View记录。

- 时间记录的误差:

在没有Cache干扰的情况下,服务器能准确探知访问开始的时间,但是访问结束的时间无法了解。因为访问结束往往是随关闭浏览器而一同结束的。关闭浏览器本身不能激发一条新的Server Log记录。

- Flash站点误差:

如果一个网站主要构成部分是包含多个页面的一个Flash文件,或多个此类Flash文件的组合,那么Server Log不会记录Flash内部的操作,监测会几乎失效。

Page Tag的误差:

- Page Tag失效:

Page Tag失效是会发生的。首先,一部分浏览器(例如手机上的一些浏览器)不支持JavaScript或者被设置为JavaScript禁止。其次,Page Tag可能会因为它之前的JavaScript出错而无法运行。再次,我们也看到过因为变量名冲突而发生Page Tag和页面上其他JavaScript冲突而无法运行的案例。最后,受网络速度的影响,页面上的Page Tag没有完全下载,浏览器就可能被人为关闭或者直接链向一个新的页面。

显然,如果Page Tag失效,那么网站分析工具就会失去部分或者全部数据。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

- Page Tag的位置:

Page Tag在页面中的位置会影响网站分析工具的计数。如果Page Tag在页面的上端,那么它会更快的被执行,受到其他因素(例如Page Tag之前其他JavaScript失效或者网速问题)干扰的情况就越小,计数也就会因此增大。Stone Temple Consulting的统计表明,代码在上的情况下,Visitor计数比在页面下的多4.3%。

- Unique Visitor的误差:

一个计算机可能被多人使用;一个计算机可能有多个浏览器(造成访问同一个网站有多个Cookie);人们会删除Cookie(2007年comScore的统计表明,一个月内有30%的美国用户会删除浏览器的Cookie);Cookie被禁用(尽管WA工具一般都使用第一方Cookie,但仍有约10%不到的第一方Cookie会被用户设为禁止)。

- Page View的误差:主要由Page Tag失效引起。

- 时间记录的误差:同Server Log一样,Page Tag能够准确记录访问开始的时间,但是结束时间无法了解,因为一般情况下访问的结束并不会触发Page Tag的执行。

由于诸如Page View,访问者和访问时间之类的基本的度量实际上是无法准确记录的,因此其他一些更高级的度量,例如我们常用的复合度量(Bounce Rate,Avg. Time on Site)就更不可能准确了。不过,知道了这些误差产生的原因,有助于我们进一步修正误差。有些监测工具(例如DoubleClick,一个广告监测工具)具有自修正功能,就是利用了这个原理。

其他监测方法的误差:

网站分析的其他获取数据的方式——比如通过客户端的软件搜集数据(Alexa,iResearch等),以及Sniffer(包嗅探)——则因其本身的监测方式所限,会有更大的误差。例如,通过客户端来搜集数据,很显然存在样本量的偏差;而Sniffer本质上是Server Log方式的翻版,但却增加了包丢失以及数据记录有限的问题。它们不可能比我们前面的两种方法更准确。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

网站分析工具精确吗?

现在,你知道了网站分析工具并不能准确计数。那么,网站分析工具精确吗?

我要说,精确是网站分析工具的必备特征,网站分析工具做不到准确,但必须精确。如果某个网站分析工具不精确,那么它就与垃圾无异。

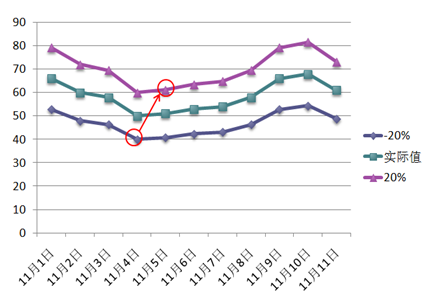

网站分析工具必须精确的原因很简单,因为我们需要数据具有高度的一致性。如图4(下图)所示,如果网站分析工具的精确度存在-20%到+20%的误差,那么假设11月4日的网站准确流量是50个UV,网站分析工具所报告的数值可能是40和60之间的任何一个数。同样,我们假设次日(11月5日)的网站准确流量是51个UV,那么网站分析工具所报告的数值可能是41到61之间的任何数。那么,因为存在不精确,那么11月4日的数据有可能最终呈现40,而11月5日的数据则完全可能被最终呈现为61,这样网站分析工具会误报出一个令人满意的增长——但事实上这个增长并不存在。反过来,如果11月4日的数据被报为60,而次日被报为41,那么更糟糕,这与实际情况是完全相反的。

图4:如果网站分析工具不精确会产生严重后果

因此网站分析工具必须精确,如果它与事实有-20%的误差,那么不论是哪一天哪一刻,它都必须比准确值小20%。否则我们就会得到错误的结论。当然,100%的精确也是不存在的,一般而言,允许+/-5%左右的系统偏差,这一来一去其实已经有最大10%的分离度,实际上已经是非常宽的标准了。

网站分析工具不能做到100%精确的原因其实也是受跟上一节的那些因素一样的影响,另外还有一些网站访问者所处环境的变化造成的未知异常,例如网络带宽的变化或是数据传输过程中的异常丢失等。

那么,我们实际使用的网站分析工具精确度如何?如果5颗星是满分最精确的话,那么:

Google Analytics,精确度3颗半星,可以及格。但是我们的朋友Ben(曾海银)和我都发现Google Analytics并不完全精确,这可能与数据的再处理有关系。Ben的案例中出现了+/-20%的情况,但极为罕见。其他的朋友有发现吗?

Omniture,精确度4颗星,较好。当然,我没有办法去验证,只是因为他们家的数据比较少给我惹麻烦,也比较少有无法解释的时候。但是Omniture的问题在于,定义的度量太多,且相同度量的定义在不同场合给出的数值有微小差异(尽管没有实质影响)——实在是一个太庞大的数据系统了。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

WebTrends,4颗星。评分较高的原因在于WebTrends是实施在网站服务器端,或者是被网站所有者所拥有的,所以被外界环境干扰的情况相对较少。

如何面对网站分析工具的不准确但精确的特性?

网站分析工具不准确但精确的特性不妨碍我们获得真正的insight(见解)。我们需要遵循三个网站分析的基本原则(简直是我压箱子底的宝贝了):

原则一:趋势。

看趋势而不是看孤立数据是网站分析最重要的原则。你不可能因为网站今天的流量是500个而狂喜,但是如果上个月的平均流量是300,而这个月的平均流量是500,那么我会恭喜你,你也值得高兴一番。我们在以前的文章中对这个有讨论哦。

由于网站分析工具是精确的,因此虽然不能准确反映数据,却能够准确反映趋势。这也是我们所有的网站分析师会认为趋势是最重要的方法论的原因。

原则二:细分。

因为网站分析工具的精确性,如果整体值比实际准确值偏小20%的话,那么构成整体的各部分也会同比比各自的准确值偏小20%。因此,比较所需要的细分仍然能够满足分析的需要。

原则三:转化。

与细分类似,精确性能够保证转化是同比放大或缩小,因此转化本身的比例是准确的。

如此看来,我们最后要得出的结论是:真正帮助我们进行网站分析的关键方法所需要的数据是准确的。因此,当我们理解并且学会运用网站分析的三原则之后,我们会把网站分析工具所在的象限转移到左上角的象限——即既准确且精确。真的,网站分析工具最终准确与否,在于你是否用好了它,这是唯心的结论,但确实是真正的真相。

祝大家好运。

[版权归作者Sidney Song(宋星)所有,欢迎转载,但请事先告知作者并注明出处]

有什么看法和建议吗?非常欢迎大家留言。看到大家的留言是最快乐的,也是最终自我满足的回报。:)

宋星的数字观

宋星的数字观

我今天也在琢磨怎么自己的GoogleAnalysis不是很准.

说到这个问题, 我有两样东西想请教.

第一,WA怎么在早期或数据较少的情况下发挥最大作用?

关注这个数据精确和准确的话, 我相信对网络营销是最重要的.

如果发动一个网络营销Campaign之前有一个测试阶段,用来收集数据为调整细节,进而获得更好的效果. 这时手头上只有几天或几周的测试数据而没有过往经验参考, 或者作为小范围测试只有少量的数据,

WA怎么能够排除统计误差和样本量太小更好地发挥作用?

第二,您是否赞成使用两个或更多网站分析工具?

既然有不准确, 那么我们对于数据就不可信任. 因此只用一个分析工具, 会不会太冒险.

但又有人说"永远不要戴两只表", 而使用多个网站分析工具可能会令你对于数据迷惑.

面对这种悖论, 如果单纯取平均值, 因为不同工具的方法是不一样的, 可能会更加伤害数据准确性. 因此这点想听听您的意见和您会怎么处理.

感谢您又写出这么有营养的文章, 我的博客刚起步, 您认真写作的态度值得学习.

感谢你的问题!非常典型的问题!

第一,WA在早期数据是精确的,早期数据尽管不多,但仍然精确。不过,我们不建议太早对网站进行分析,通常需要积累到一定的数据,至少一周,才能看出点儿端倪。如果2个星期积累的统计数据仍然小,那本身说明网站的流量就是问题本身。

第二,不赞成。因为数据差异的原因会让你陷入很多迷惘,而可能忽略对真正有意义数据的分析。网站分析的准确一般而言意义不大,而且帮助我们分析的数据实际上能够基本准确。更重要的是精确,精确就能帮助我们进行分析。所以我一个网站只用一个工具。如果因为客户的要求而使用两个或以上的工具,我会选择技术实施更可靠的那个作为数据依据,其他仅作参考。

祝你的博客越办越好!互相学习!:)

好文,以前只注意到准确度,而忽视了精确度。我想,数据越精确,分析趋势、细分等就更有意义。另外,精确度和样本的大小也有关系,如果数据太少,就容易产生偏差。

物理学实际上也是不可能100%准确的,这个确实是,因为物理实验的会受到很多外因的影响,而且环境也不可能达到理想的诸如“真空”,“光滑”等,但不是因为“测不准原理”,测不准原理是量子学上的原理,不是字面上理解的“测不准”,呵呵

感谢指正!这个已经到物理学层面上了,可惜我的物理学没有学好,尤其是量子力学。:)

测不准原理不是字面上的,因为更准确的表述应该是“不确定性原理”,是观测对象本身的属性,而不是外部环境。

不过,哲学上看,不存在100%的纯粹,也就不存在100%的准确。

向大师学习中。。。。。

非常精彩!

特别是最后如何面对的方法:趋势、细分和转化。

我有另一个问题想请教:

文章中提到的都是纯分析网页行为数据,如果网页行为数据和最终的实际结果数据结合的分析,

例如我们在做活动细分的时候,会看两个东西:流程页面转化率和最终的产能(产品销售金额和产品销售件数)。

在做活动投放和活动细分时,行为数据的记录方式和实际产能的记录方式肯定是不同的,

目前我们的产能是使用cookies记录客户来源,最终成交就会被记录下来。

对这种差异有该如何看待和面对呢?或者应该会有更好的办法来协调?

呵呵,不知道是否大家在分析的时候是否会遇到这种情况呢?

很精辟,帮你转载到6351

赞同你的原则,事实上,客户行为的分析,也不能仅仅依赖流量的数据,还有其他的工具和方法可以获得更具洞察力的结果。Avinash的web analytics 2.0模型给我们很多启发。

期待你更多的分享,很高兴在上海见到你:)

非常感谢宋星这么耐心和详细的说明。说两个问题:第一,如果只对站点统计数据分析,我认为还是不足以解决问题,至少这些数据只能算是定量分析,而且已经统计到得数据是有一定滞后性的,如果某些滞后性的数据调整,可能会错失一些热点。那么我在想,数据的在不准确的情况下,我们如何对现有数据进行归集和细分样本抽取,那么如何定义归集和如何抽样,就不单单是量的问题?我想过这样一个分析,比如跟踪三个月的数据,以某种单品的用户订单点击轨迹作为标准抽样,跟踪用户预订点击轨迹和中间的流失率和完成预订率,那么这种抽样是不是不管数据精确与否,都是可以发现问题的呢?所以 想问下宋星前辈,能否写篇文章说下定量和定性分析结合的实例分析?

第二,看过一些网站分析行业的数据,发现国内在网站分析这块非常欠缺,而且对分析师所具备的能力说法都不一,如果依你的经验和观点,合格网站分析师需要具备哪些基本能力,比如程序架构、比如数据挖掘、比如智能分析系统构建等等?第三,能否推荐一些国外网站分析交流的论坛、博客、行业站点?谢谢!感谢你的问题。

1. 会要释放一些关于这方面的案例。其实我认为所有的分析最终的结论都是定性的。而量化是对定性的帮助。

2和3. 请看我此前的文章:http://www.chinawebanalytics.cn/?p=519。

真正帮助我们进行网站分析的关键方法所需要的数据是准确的。

最后一段的这句话,应该是“精确”吧?

用Omniture 监测到的媒体的点击数据比媒体提供以及其他第三方监测到的数据少很多。而且主要是门户网站。如Sina/Sohu。

请教一下:除服务器(在国外)以及监测方式(监测的数据为进入目标页)的原因外,可能导致的此问题的其他原因有哪些?

当我们同时在用多家媒体监测工具,发现数据在趋势上都很不一致的时候,该怎么查?从哪里下手?虽然趋势很重要,但是在目前国内媒体数据相对混乱的阶段,怎样才能提高自己的分析能力?或者是否可以解说一下中国网络的现状?以及要怎样结合这样的现状去分析追踪的数据?

期待您的高见啊~~ 让人苦恼的数据

感谢Sidney的文章。老实的讲我并不能算是严格意义上的新手。在Digital Marketing领域做过很多网络行为追踪与分析的案子。目前客户普遍的不信任媒体的数据,所以会找第三方来协助监测数据。有些公司基于公司政策甚至于会同时使用3家以上的监测工具。这其中会包括:Double Click(现在已经和Omniture合并),GA, Omniture , HBX,好耶、、、但是上述这些监测工具技术原理上都会有或多或少的不一样。单从媒体Banner的点击监测就会有有差异。追踪的原理会直接导致数据的差异,作为业内人士,相信大家都对媒体灌水的现象有所耳闻,这样拿到的各方的数据就千查万别。甚至像我们碰到的:数据差异大情有可原,可怕的是连趋势都不一致。由于我们一般会将媒体数据与网友在网站的行为数据进行整合分析,这样的情况往往导致我们的时间不是在分析本身,而是要去先甄别数据是否可靠。本末倒置!

对于这样的状况,想必Sidney 也许也有些许感慨、、、

长期一直盲目的作seo ,一位有了排名就是一切,结果 读了老师的文章 才明白 分析 也是很重要的一个环节, 希望可以有更多好的作品

你好宋星,一直在关注《网站分析在中国》,也一直在你这里偷学知识。

上次在北京robin club的聚会上你的演讲让我学到不少的新东西,我回来就应用到一些网站上了,对网站帮助很大!

谢谢。。。

请教个问题。

如果一个访问者通过关键字A进入了网站,访问了30分钟后,cookie被重置,visit加1。这时候,其他的统计量会发生变化吗?比如增加的这次visit的landing page什么计算?

趋势对比大概更适用于网站自己分析自己,是一种纵向的对比。但如果是某个广告活动选择媒体进行投放时,那么很可能需要横向对比媒体覆盖目标受众的绝对值了,这时数值就要比趋势更重要吧 ?不知Sidney怎么看?

是的,我也很同意趋势也是一种非常重要的分析方法。我认为,网站分析最基本的三种分析方法是:细分、趋势和转化。

谢谢你的文章,受益了。

不过我有个问题。最近在国外,特别是美国对网络隐私的讨论很热烈。许多主流的浏览器都在打算提供“DO NOT TRACK”的选项。我对这种趋势比较的担心,如果在浏览器上边有个“DO NOT TRACK”的按钮,那么我们的数据很有可能收到很大的pollution。你对此是怎么看的?

谢谢

<a href="http://www.seinei.com" title="网络分析">一个很搜索引擎优化的人</a>嗯,虽然是很久以前的文章了,但还是留言一下吧。

说到精准,之前公司的技术自己记录点击流日志,做了一个统计分析系统。我们分站比较多,有近30个二级域名,最后和ga的PV对比了下,平均下来ga要比自己记录到的,少20%不到一点,不同的二级域名上下有稍许浮动。具体数字记不清楚了,差不多就是这样一个情况。

你的这篇文章让我受益匪浅,一直因网站数据不准确而苦恼,经过您条理性的总结,很有启发。当你的网站所有的很多数据出现问题时,您压箱底儿的三个宝贝儿还是能派上用场。

压箱子的宝贝确实是好东西~~~~

宋老师,学习初期,面对GA无从下手,我想让老师指点一两个入门的操作。谢谢。

谢谢 受益了